Hồi tháng 1, nữ diễn viên, người mẫu người Mỹ gốc Ý Julia Fox đã vô tình bị hứng chỉ trích, sau khi để lại bình luận dưới một video TikTok khó hiểu.

Cụ thể, trong một clip được đăng tải, TikToker Conor Whipple kể rằng: "Tôi đã tặng mascara cho một cô gái và nó tuyệt đến mức cô gái đó quyết định rằng cô ấy và bạn của mình sẽ cùng thử nó mà không cần sự đồng ý của tôi".

Phía dưới phần bình luận, Julia Fox viết: "Tôi không hiểu vì sao nhưng tôi không thấy có gì đáng buồn về việc đó".

Whipple tức giận đáp trả: "Bạn không cảm thấy tồi tệ khi tôi bị tấn công tình dục ư?”.

Thực ra, Julia không hề hay biết, thuật ngữ “mascara” được dùng với ý nghĩa "tình dục” trên nền tảng mạng xã hội này. Người dùng TikTok sử dụng nó như một từ được mã hóa để thảo luận về hành vi tấn công tình dục, nhằm lách luật kiểm duyệt của ứng dụng.

Trên TikTok, "mascara" chỉ là một trong nhiều thuật ngữ gọi chung là "algospeak" (chỉ các thuật ngữ mà người dùng mạng xã hội sáng tạo để đánh lừa hệ thống kiểm duyệt nội dung tự động của AI).

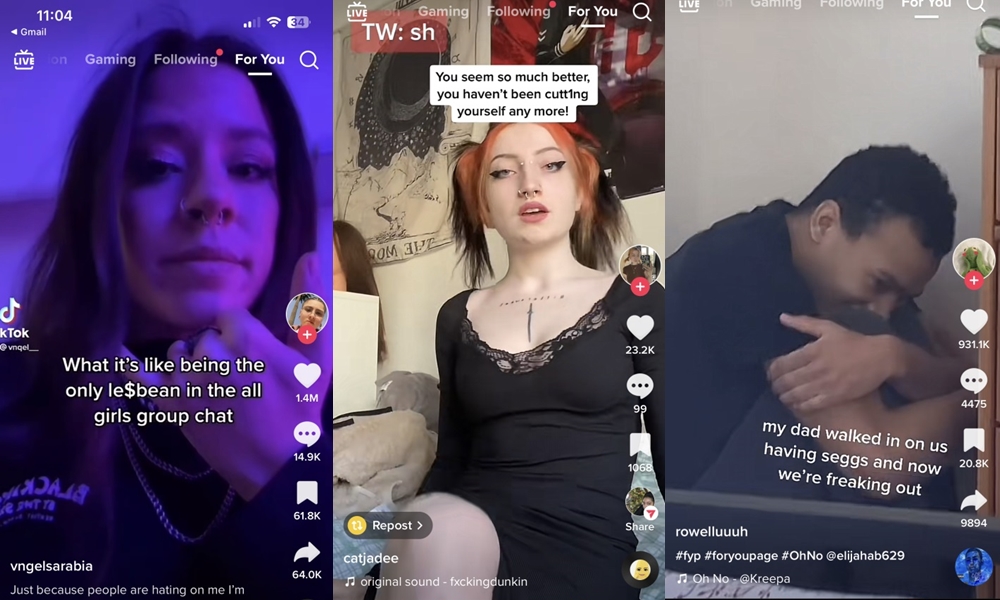

Để lách luật kiểm duyệt của TikTok, đôi khi các thuật ngữ không liên quan như "mascara", "ana", các từ không có nghĩa nhưng có phát âm gần giống từ gốc như "seggs" (sex - tình dục) hay cutt1ing (cutting - cắt/tự hại), "unalive" (dead - chết) đã được tạo ra.

"Yt people" cũng được sử dụng rộng rãi để nói về người da trắng hay từ "Le$bean" dùng để thay thế người đồng tính nữ trong các video. Khi nhắc đến chất cấm, những thuật ngữ như "snow" (tuyết) hay "skiing" (trượt tuyết) cũng là những từ được sử dụng.

Mặc dù "algospeak" giúp người dùng TikTok nói lên suy nghĩ của họ mà không sợ bị kiểm duyệt, nhưng nó đồng thời cũng cho phép những nội dung nguy hiểm tiềm ẩn lan truyền mạnh mẽ.

Nguy hiểm hơn, các từ mã hóa đang cho phép trẻ em truy cập những nội dung liên quan tới việc tự tử, tự làm hại bản thân.

Theo chuyên gia về trí tuệ nhân tạo Vince Lynch: “Trước đây, các hành vi bất hợp pháp thường xảy ra nhiều hơn và dễ dàng phát hiện hơn khi các đối tượng cố gắng tìm kiếm thị trường của mình. Tuy nhiên, hiện tượng mã hóa các từ ngữ đang ngày càng phổ biến và gây khó khăn cực lớn cho việc kiểm duyệt nội dung”.

Theo dữ liệu riêng của công ty, TikTok đã xóa bỏ 110 triệu video chỉ trong khoảng thời gian từ tháng 7 đến tháng 9 năm 2022, chiếm khoảng 1% tổng số nội dung được đăng lên ứng dụng.

Khoảng 50% số video đã tự động bị xóa bởi AI được phát hiện chứa nội dung bị cấm. Đó là lý do tại sao những người sáng tạo nội dung đã bắt đầu thay thế các từ ngữ có sắc thái mạnh, nhạy cảm bằng các thuật ngữ được mã hóa.

Theo một cuộc khảo sát do TELUS International thực hiện, 51% người dùng internet nói rằng họ đều nhận ra được các từ lóng được dùng trên TikTok. Nếu chỉ xét riêng những người dùng thuộc thế hệ Gen Z , con số này thậm chí tăng vọt lên tới 72%, cho thấy sức ảnh hưởng và phổ biến của các từ lóng này.

Theo nguyên tắc cộng đồng của TikTok, ứng dụng này không cho phép nội dung mô tả, lan truyền hoặc tôn vinh các hoạt động có thể dẫn đến tự tử, tự làm hại bản thân hoặc rối loạn ăn uống.

Theo đó, người dùng khi tìm kiếm từ khóa "tự tử" trên nền tảng này sẽ được chuyển hướng đến đường dây nóng hỗ trợ khủng hoảng tự sát. Và những người tìm kiếm từ khóa "chán ăn" sẽ được cung cấp số điện thoại của Hiệp hội Rối loạn Ăn uống Quốc gia.

Tuy nhiên những biện pháp trên chẳng có ý nghĩa gì khi các từ mã hóa được sử dụng. Mặc dù công nghệ tiên tiến đằng sau việc kiểm duyệt nội dung đang đổi mới nhanh chóng nhưng ông Lynch lo ngại rằng việc này sẽ khiến cách lách luật ngày càng đa dạng và khiến việc kiểm duyệt nội dung mãi mãi bế tắc.

"Càng có nhiều quy định được đưa ra thì người dùng sẽ càng tìm ra nhiều cách hơn để lách luật" – ông Lynch nói.

Mộc Miên (Theo New York Post)